Nvidia anuncia GPU H100 como maior e mais poderoso acelerador do mundo

Por Renan da Silva Dores | Editado por Wallace Moté | 22 de Março de 2022 às 16h40

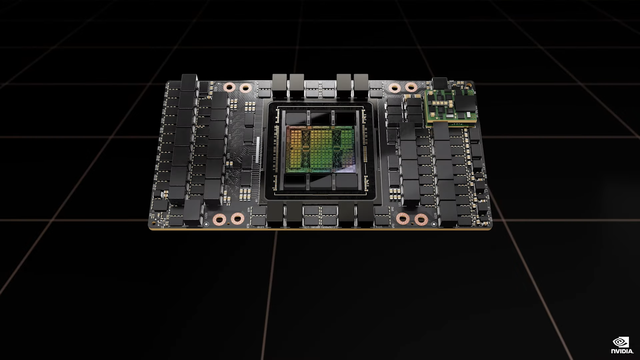

Durante a GTC 2022, a Nvidia anunciou a nova microarquitetura Hopper, que alimentará as soluções para servidores e supercomputadores da companhia nos próximos anos, liderados pela GPU Nvidia H100. Com foco em turbinar o processamento de Inteligência Artificial, a novidade promete ser o maior e mais poderoso acelerador de processamento de dados do mundo.

- AMD lança chips EPYC 7003X Milan-X com até 768 MB de 3D V-Cache

- Nvidia RTX 3080 fica 35% mais barata após rumores da redução de preços das GPUs

Nvidia anuncia arquitetura Hopper

Sucedendo a arquitetura Ampere anunciada há dois anos, a arquitetura Hopper homenageia a pioneira em Ciência da Computação e criadora da linguagem COBOL, Grace Hopper, e alimenta o novo chip GH100, equipado no centro da GPU Nvidia H100. A solução é fabricada no processo 4N de 4 nm da TSMC, customizado para a Nvidia, e integra 80 bilhões de transistores, 50% a mais que a geração anterior, a Nvidia A100 com chip GA100.

A implementação completa do GH100 embarca 144 Streaming Multiprocessors (SMs) com 128 núcleos CUDA cada, totalizando 18.432 núcleos, 2,25 vezes mais que o GA100. O lançamento também embarca 4 Tensor Cores de 4ª geração por SM, para um total de 576, capazes agora de realizar cálculos com dados no novo formato FP8, que seriam até 6 vezes mais velozes que o desempenho de FP16 da A100, o maior salto dado pela empresa em uma geração.

O componente traz 60 MB de cache L2 e é a primeira GPU do mundo a ser compatível com o barramento PCIe 5.0, até então exclusivo das CPUs Alder Lake da Intel, e estreia as novas memórias HBM3, com 3 TB/s de largura de banda. A Nvidia destaca que 20 unidades da H100, com até 6 chips de memória cada, teriam largura de banda de memória suficiente para sustentar o tráfego da internet mundial.

Há ainda algumas novidades proporcionadas pela nova arquitetura: uma Transformer Engine, focada em acelerar em até 6 vezes o processamento de reconhecimento de linguagem, foi integrada, bem como capacidade de processamento confidencial, que isola os dados e a aplicação em execução, característica até então presente apenas em CPUs.

Completa o conjunto de inovações a 4ª geração do NVLink, barramento de comunicação proprietário da Nvidia, que agora dobra de velocidade e permite transferências de até 900 GB/s, bem como um novo conjunto de instruções, o DPX, dedicado a algoritmos de programação dinâmica, prometendo 7 vezes mais performance que a A100 em processamento dedicado à pesquisa de genomas, otimização de rotas para robôs autônomos e mais.

Com essas novidades, a Nvidia H100 consegue manter até 7 instâncias de máquinas virtuais, cada uma com o desempenho equivalente a uma Nvidia T4, atual placa para máquinas virtuais mais adotada da marca. Preparada para resfriamento por ar ou líquido, a nova GPU tem consumo de até 700 W, a depender do modelo, cerca de 300 W a mais que a Nvidia A100.

Nvidia H100 em variados formatos

A Nvidia H100 será oferecida essencialmente em dois formatos — SXM e PCIe — para atender a diferentes tipos de servidores. O primeiro traz uma versão mais robusta do chip GH100, com 132 SMs, abrigando 16.896 núcleos CUDA e 528 Tensor Cores, acompanhados de 5 chips de memória HBM3 com 16 GB cada, em um total de 80 GB com interface de 5.120-bit, gerenciado por 10 controladores de 512-bit cada, para oferecer largura de banda de 3 TB/s.

A solução oferece 60 TFLOPs em FP32 e 4 PetaFLOPs (4.000 TFLOPs) no novo formato FP8, traz 50 MB de cache L2 habilitado, suporta barramento PCIe 5.0 e tira proveito da 4ª geração da conexão NVLink para possibilitar a colaboração de até 8 unidades em conjunto, na nova unidade de computação HGX H100 da empresa, cenário em que atinge os 480 TFLOPs em FP32, ou 32 PetaFLOPs em FP8.

Já a Nvidia H100 no formato PCIe 5.0 é mais modesta, trazendo 114 SMs habilitados, contando assim com 14.592 núcleos CUDA e 456 Tensor Cores — essa combinação atinge os 48 TFLOPs em FP32, ou 3,2 PetaFLOPs em FP8. A memória sofreu ligeiras modificações: ainda há 50 MB de cache L2 e até 80 GB de RAM, mas do tipo HBM2e, em uma interface de 5.120-bit, para entregar largura de banda de 2 TB/s.

Buscando driblar eventuais limitações de comunicação causadas pelo barramento PCIe ou gargalos de memória em cargas de trabalho que manipulem uma quantidade massiva de dados, a Nvidia também trabalhou em um novo tipo de acelerador no formato PCIe, a chamada Nvidia H100 CNX. A novidade combina a H100 com um chip de rede de alta velocidade ConnectX-7 da empresa para possibilitar que a GPU tenha acesso direto aos dados transferidos pela rede.

DGX H100 POD e o supercomputador EOS

Os sistemas HGX H100 atuam como blocos de construção para sistemas ainda mais complexos. Uma unidade forma o DGX H100, sistema completo que fornece até 32 PFLOPs de poder computacional em FP8 e, por sua vez, a junção de 8 dessas soluções forma o DGX H100 POD, que entrega 1 ExaFLOP (EFLOP) de processamento, 20 TB de memória HBM3 e utiliza a conexão NVLink para trabalhar em conjunto.

A Nvidia então uniu 18 DGX H100 PODs para formar o Nvidia EOS, mais novo supercomputador da gigante que promete se tornar o maior e mais poderoso do mundo para Inteligência Artificial. A máquina entrega 18 EFLOPs de poder computacional, e supera assim em 4 vezes o atual campeão de desempenho, o supercomputador japonês Fugaku.

De acordo com a fabricante, o EOS atuará como um modelo para o desenvolvimento de infraestrutura de IA tanto para a própria Nvidia, como para outras parceiras de supercomputação na nuvem.

Nvidia Grace Hopper une CPU Grace com H100

Aproveitando os anúncios, a Nvidia também revelou uma nova conexão NVLink dedicada a combinar diferentes CPUs e GPUs, a chamada NVLink C2C (Chip-to-Chip), que entrega velocidades de 900 GB/s e será implementada em futuras soluções da marca.

A novidade habilita o novo Nvidia Grace Hopper, conjunto de processamento que une a CPU Grace, anunciada pela empresa no ano passado, com uma GPU H100 para se tornar o sistema de computação acelerada mais denso da companhia.

O NVLink C2C também alimenta o Grace CPU Superchip, que une duas CPUs Grace para atingir os 144 núcleos de processamento, 396 MB de cache e embarcar RAM LPDDR5X com correção de erros (ECC) e largura de banda de 1 TB/s. Segundo a Nvidia, o Superchip consome apenas 500 W, apresentando performance por Watt 2 vezes superior a concorrentes.