Nvidia anuncia servidores com CPU Grace para streaming de jogos, IA e mais

Por Renan da Silva Dores | Editado por Wallace Moté | 24 de Maio de 2022 às 19h04

Entre seus anúncios para a Computex 2022, a Nvidia revelou 4 servidores de referência para diferentes cargas de trabalho, incluindo streaming de jogos, gêmeos digitais, Computação de Alta Performance (HPC) e treinamento de Inteligência Artificial. Previstos para 2023, esses sistemas serão fabricados por grandes parceiras e utilizarão o poder de processamento da CPU ARM Nvidia Grace e da recém-anunciada GPU H100 "Hopper".

- ASUS e Nvidia anunciam primeiro monitor gamer de 500 Hz do mundo

- AMD Ryzen 7000 promete até 31% mais velocidade que Core i9 12900K

Nvidia anuncia servidores de referência com chip Grace

Durante a apresentação, a Nvidia destacou como os data centers vêm se tornando "fábricas de IA", cada vez mais acelerados com o uso de Inteligência Artificial. A empresa quer intensificar essa rota e anunciou quatro novos servidores de referência equipados com CPUs Nvidia Grace e GPUs Nvidia H100: o CGX, para streaming de games e computação gráfica, o OVX, para gêmeos digitais, e duas versões do HGX, para HPC e treinamento de IA.

Nesse primeiro momento, o destaque vai para as variantes do HGX, destinadas a processamento intenso de dados. A primeira é a HGX Grace, alimentada pelo Nvidia Grace Superchip — utilizando a quarta geração do NVLink C2C, que conecta dois chips em um com largura de banda de 900 GB/s, o componente oferece 144 núcleos ARMv9 e até 1 TB de RAM LPDDR5X, com largura de banda de 1 TB/s.

A comunicação com outros racks e a rede é feita pela DPU Bluefield-3, que possui um processador próprio para acelerar a transferência das informações, enquanto as conexões ficam a cargo da fabricante do servidor. O foco do HGX Grace são as cargas de trabalho de HPC, como análise de dados, simulações e outras tarefas de áreas científicas e de engenharia.

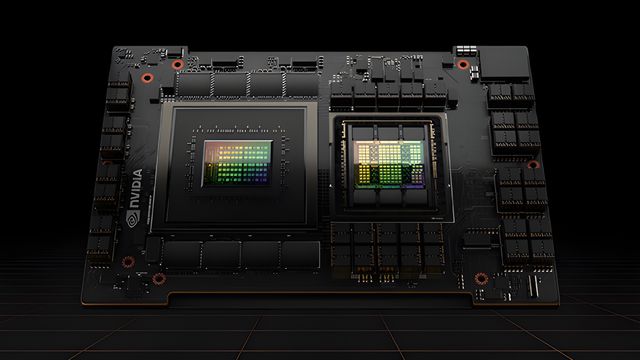

O segundo modelo é o HGX Grace Hopper, munido do Nvidia Grace Hopper Superchip — ainda utilizando o NVLink C2C, uma CPU Grace de 72 núcleos é interligada a uma GPU H100 "Hopper", mais nova solução da empresa que seria "o acelerador de IA mais rápido do mundo". Por aqui, são 512 GB de RAM LPDDR5X do sistema, unidas a 80 GB de memória HBM3 da H100, para oferecer grande largura de banda de 3,5 TB/s.

Assim como o HGX Grace, a conexão a outros racks e à rede também fica sob responsabilidade da Bluefield-3. Ainda que seu foco seja a inferência e o treinamento de Inteligência Artificial, o modelo também visa atender cargas de trabalho de HPC.

Poucas informações foram dadas sobre o CGX e o OVX: ambos também utilizarão o Grace Superchip como CPU, assim como o Bluefield-3 para a alta transferência de dados, mas enquanto o primeiro adota GPU A16, modelo baseado na arquitetura Ampere para data centers dedicados a processamento gráfico, o segundo embarcará "GPUs Nvidia" não especificadas. Os quatro modelos de servidores serão fabricados por parceiras como ASUS, Foxconn, Gigabyte e Supermicro.

A Nvidia confirmou ainda mais alguns detalhes interessantes sobre sua estratégia para data centers: além de manter um roadmap denso de 2 anos, com um ano focado em servidores x86 e outro em soluções ARM, a empresa reforçou que adotará o padrão UCIe. A interface aberta de comunicação entre chiplets, desenvolvida pelo consórcio de gigantes como AMD e Intel, permite que componentes de diferentes fabricantes conversem entre si em um mesmo substrato.

GPUs A100 e H100 com resfriamento líquido são reveladas

Ainda tratando de novidades para servidores, a gigante reforçou seu compromisso em acelerar a computação sem deixar de lado a sustentabilidade ao anunciar modelos PCIe da A100 e da H100 equipados com resfriamento líquido. Essas soluções entregariam ainda mais desempenho que as variantes PCIe tradicionais, resfriadas por ar, ao mesmo tempo em que reduziriam o consumo de energia, já que haveria menos esforço e gastos para refrigerar as placas.

Nos testes da Nvidia, a A100 com refrigeração líquida conseguiu cumprir as mesmas cargas de trabalho da versão tradicional consumindo 30% menos energia. Pelas estimativas da companhia, utilizar esses modelos para substituir CPUs em servidores de HPC e treinamento de IA resultaria em uma economia massiva de 11 trilhões de Watts-hora.

Os novos servidores de referência com chips Grace e Grace Hopper estreiam no primeiro trimestre de 2023, junto da GPU H100 com resfriamento líquido. A nova A100 com refrigeração líquida chega antes, no terceiro trimestre de 2022, entre os meses de julho e setembro.

Fonte: Nvidia, XDA Developers, TechRadar