AMD lança linha Instinct MI300 com foco em IA e 1ª APU para servidores

Por Renan da Silva Dores | Editado por Jones Oliveira | 06 de Dezembro de 2023 às 17h00

Além dos novos Ryzen 8040 para consumidores, a AMD lançou nesta quarta-feira (6) a linha Instinct MI300, embarcando aceleradores dedicados para Inteligência Artificial e Computação de Alta Performance (HPC) nos servidores. Já mostrada em breves apresentações no passado, a família chama atenção por prometer ser uma revolução das soluções da gigante para data centers, não apenas empregando a nova arquitetura CDNA 3 focada em computação, como ainda por oferecer a primeira APU (combinação de CPU e GPU) para o segmento.

- Intel Xeon Clearwater Forest pode ter 288 núcleos, diz rumor

- Dell investe em cluster para IA com 10 mil GPUs Nvidia H100

Instinct MI300X supera H100 em até 2,4x

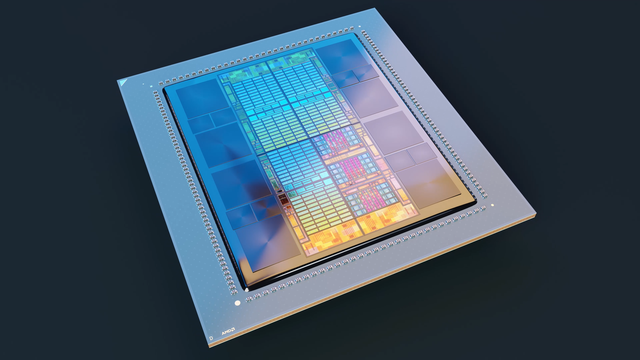

A primeira das novidades é a Instinct MI300X, modelo de acelerador que emprega um design "padrão" de GPU para data center, ainda que haja uma série de novidades ao olharmos para o interior da solução. O lançamento embarca a nova microarquitetura CDNA 3 (Compute DNA 3), focada no processamento de dados, e evolui a construção de múltiplos dies vista na geração anterior ao adotar a mais flexível construção com chiplets, com "empacotamento 3,5D", que combina em um pacote chiplets empilhados lado a lado e uns sobre os outros.

Em sua configuração máxima, a MI300X é composta de oito dos novos XCDs (Accelerator Complex Die, ou circuito de complexo de acelerador em tradução livre), os chiplets que contêm as estruturas de processamento, acompanhados de quatro I/O Dies, onde estão os controladores de conectividade da GPU, e oito chips HBM3, totalizando 192 GB de memória com largura de banda de 5,3 TB/s.

Há ainda 256 MB de Infinity Cache, para acelerar as transferências entre os XCDs e a memória, enquanto o Infinity Fabric, responsável pela comunicação entre os próprios XCDs, atinge velocidades de 896 GB/s, que seriam suficientes para impedir que o tráfego de dados entre os diferentes chiplets não gere impactos de desempenho. Os números impressionantes seguem ao olharmos os XCDs mais de perto: cada um deles possui 38 Unidades Computacionais (CUs), podendo chegar às 304 em uma única MI300X.

Segundo a AMD, a novidade seria capaz de entregar até 163,4 TFLOPs de poder computacional para dados no formato FP64 de alta precisão, quando organizados em matrizes, ou 81,7 TFLOPs ao serem usados vetores. Para o formato FP32, também de alta precisão, a capacidade atingiria 163,4 TFLOPs, mas tanto em matrizes quanto em vetores, neste caso. Outro formato interessante que tem ganhado força em aplicações de IA é o INT8, de baixa precisão, em que a MI300X ofereceria até 2.615 TOPS (Trilhões de Operações por Segundo).

Quando comparado à sua principal rival, a Nvidia H100, o acelerador do time vermelho se destaca ao ser até 2,4 vezes mais veloz em FP64 (a H100 entrega até 66,9 TFLOPs), até 2,4 vezes superior em FP32 (frente aos 66,9 TFLOPs da GPU da Nvidia) e até 30% mais potente em INT8 (comparado aos 1.980 TFLOPs da H100). As vantagens seriam obtidas com consumo de pouco mais de 750 W, em comparação aos 700 W da H100, o que resulta em diferença de apenas 7%, demonstrando grande eficiência da MI300X.

Companhias interessadas no lançamento, especialmente as voltadas para desenvolvimento de tecnologias de IA generativa, poderão adquirir a Instinct MI300X Platform, sistema que combina oito dos novos aceleradores em um único conjunto. A máquina entregaria cerca de 10,4 PFLOPs (Petaflops, o equivalente a 1.000 TFLOPs cada) nos formatos de dados BF16 e FP16, de precisão intermediária, e traria 1,5 TB de memória HBM3, mantendo a comunicação veloz de 896 GB/s entre cada chip.

Comparado ao H100 HGX, sistema da Nvidia com configurações similares, a MI300X Platform teria 2,4 vezes mais memória (contra os 640 GB do HGX), 30% mais computação em FP16/BF16 (frente aos 7,9 PFLOPs do time verde), e ofereceria capacidades similares de comunicação externa via cabos Ethernet de 400 Gbps e de expansão com pistas PCIe 5.0.

Lidando com o kernel (o "núcleo" de um sistema de software) de Grandes Modelos de Linguagem (LLMs) como o Llama 2 da Meta (antigo Facebook), a máquina da AMD poderia ser até 60% mais veloz que o concorrente da Nvidia, com latência (o atraso no processamento) até 40% menor.

Instinct MI300A é 1ª APU de data center

Para uma abordagem mais híbrida, que também atenda a tarefas de HPC (que inclui pesquisas científicas, simulação de física avançada e desenvolvimento de medicamentos, por exemplo), a AMD apresentou a Instinct MI300A, considerada a primeira APU para servidores. O componente tira proveito da arquitetura de chiplets da MI300X para substituir dois XCDs por três CCDs (Core Complex Die, ou circuito de complexo de núcleos) Zen 4, os mesmos usados na linha EPYC 9004, e até nos Ryzen 7000 para consumidores.

Ainda que a maior parte das especificações da MI300X sejam mantidas na MI300A, ajustes inevitáveis ocorrem para abrigar os CCDs. Assim sendo, a solução combina seis XCDs e três CCDs, totalizando 24 núcleos de CPU e 228 CUs para aceleração, e reduz o total de memória para 128 GB, apesar de ainda termos oito chips HBM3 e 5,3 TB/s de largura de banda. Por outro lado, os 256 MB de Infinity Cache e os quatro I/O Dies permanecem integrados por aqui.

A estrutura de APU (que combina CPU e GPU em um único pacote), mais comum em notebooks, traria grandes benefícios às cargas de trabalho de IA e HPC. O segredo estaria na chamada "4ª geração da Infinity Architecture" — enquanto sua antecessora permitia uma comunicação veloz entre as CPUs EPYC e as placas Instinct, a novidade unifica tudo em um único pacote, reduzindo drasticamente o tempo necessário para haver uma troca de dados. A ideia é similar ao sistema de memória unificada usado pela Apple nos processadores Apple Silicon.

Outras vantagens incluiriam um compartilhamento dinâmico de energia, para assegurar maior eficiência, e maior facilidade de programação dos códigos, em virtude da comunicação integrada da CPU e GPU. De acordo com a companhia, essas características permitiriam à MI300A proporcionar até 122,9 TFLOPs em FP64 com matrizes, e 61,4 TFLOPs usando vetores, além de 122,6 TFLOPs para processamento em FP32 e 1.962 TOPS em INT8.

Para esses números, a AMD optou por fazer a comparação com a H100 SXM, módulo com uma GPU da Nvidia para servidores que entrega 66,9 TFLOPs em FP64 e FP32, e 1.980 TOPS em INT8, dando vantagens de até 80% para a MI300A nos cálculos de alta precisão, ainda que haja paridade no processamento de baixa precisão. Em tarefas de HPC, como o OpenFOAM para simulações físicas, a memória unificada, a nova arquitetura e o software aprimorado garantiriam quatro vezes mais velocidade frente à rival da Nvidia.

O maior trunfo da APU do time vermelho seria o consumo, que fica entre 550 W e 760 W, contra 700 W da H100. Na comparação com a GH200, que combina em um mesmo pacote a H100 com a CPU Grace da Nvidia, a MI300A entregaria duas vezes mais performance por Watt. Nesse caso, a comparação é curiosa por não trazer os dados de desempenho, sendo necessário esperar por mais detalhes. Independente disso, esses aspectos seriam parte do plano 30x25 da empresa, que prometeu aumentar a eficiência de data centers em 30 vezes até 2025.

ROCm 6 estreia focado em IA

Para tirar melhor proveito dos avanços de hardware oferecidos pela família Instinct MI300, a AMD anunciou ainda o ROCm 6, nova versão da suíte de software da marca destinada a facilitar o desenvolvimento de aplicações nas CPUs e GPUs da empresa. A atualização tem como principal foco otimizações voltadas para IA generativa, embarcando aprimoramentos em três frentes: otimizações para LLMs, adição de livrarias de alta performance para IA, e expansão do suporte ao ecossistema com novas parcerias.

Com isso, o time vermelho promete que um sistema equipado com a MI300X trabalhando com o ROCm 6 oferece latência oito vezes menor em comparação a um servidor munido da MI250, rodando software produzido com o ROCm 5. Também haveria vantagens frente à Nvidia H100 ao executar, por exemplo, um modelo de 13 bilhões de parâmetro baseado no Llama 2, com latência 20% menor.

Em relação ao ecossistema, a suíte atualizada recebe mais de 62 mil modelos e uma livraria integrada da Hugging Face, compatibilidade total com soluções PyTorch, e contribuições de soluções de código aberto como ONNX Runtime, TensorFlow, Triton da OpenAI, OpenXLA, entre diversas outras.

El Capitan e servidores com MI300

A AMD concluiu a apresentação relembrando que o El Capitan, supercomputador em instalação nos EUA aguardado para ser o mais veloz do mundo, ao ser o primeiro a quebrar a barreira dos 2 ExaFLOPs de poder computacional, utilizará centenas de MI300A. Custando cerca de US$ 600 milhões (~R$ 2,9 bilhões), a máquina extrema está prevista para entrar em operação já em 2024.

Fora isso, também foram anunciadas as parceiras que apostarão na linha MI300, fornecendo servidores para empresas, laboratórios e outras organizações. No caso da MI300X, estão entre as revendedoras a Dell, Gigabyte, HP Enterprise, Lenovo, Supermicro e QCT, entre outras, com soluções de infraestrutura baseadas na MI300X sendo oferecidas por Aligned, Arkon Energy, Cirrascale, Crusoe, Denvr Dataworks e Tensorwave. Já para a MI300A, são listadas Eviden, Gigabyte, HP Enterprise e Supermicro.