Crítica | Coded Bias usa didatismo para explicar terror por trás dos algoritmos

Por Felipe Demartini | Editado por Jones Oliveira | 06 de Abril de 2021 às 21h20

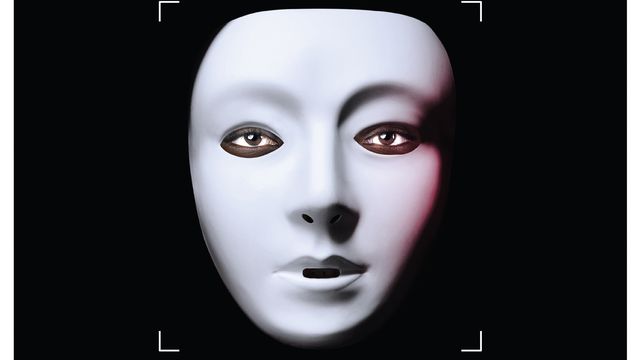

A perturbadora imagem de uma máscara branca sobre uma pele negra que mal pode ser vista poderia muito bem ter saído de um filme de terror, como tantos disponíveis na Netflix. É essa a cena, também, que abre o documentário Coded Bias, uma das estreias da semana do serviço e que serve como ponto de partida para uma realidade ainda mais aterrorizante à qual todos estamos, em maior ou menor grau, submetidos.

- Os lançamentos da Netflix em abril de 2021

- Sistema de reconhecimento facial é considerado ilegal por corte do Reino Unido

- Sem consentimento, pesquisas de reconhecimento facial usam selfies do Instagram

O título em inglês é claro, assim como a intenção de mostrar as diferentes maneiras pelas quais o viés embutido nos algoritmos pode manchar um currículo ou alterar a vida das pessoas além de, apenas, sugerir publicidade, uma música para ouvir ou o próximo filme que você vai assistir. A conversa, aqui, vai além da manipulação de escolhas para um campo bem mais negativo, onde a opção pessoal não é mais relevante e acaba sendo completamente suplantada por tecnologias vendidas como justas e imparciais, sem efetivamente serem.

São diversos os exemplos citados ao longo dos 90 minutos de exibição do documentário, que desde o início faz questão de diferenciar realidade de ficção. Aqui, não estamos falando de robôs voadores nos perseguindo, máquinas armadas e descontroladas ou situações “muito Black Mirror” — pelo contrário, e com o perdão do meme, a realidade se mostra cada vez mais próxima de algumas das visões da série de Charlie Brooker, com a diferença de que, no mundo real, não temos protagonistas nem heróis. Todos nós estamos nessa mesma onda e, se a tecnologia assim decidir, somos também descartáveis.

Essa, podemos dizer, talvez seja a única efetiva isenção dos algoritmos que gerenciam sistemas de auxílio financeiro a famílias pobres, avaliam nosso ritmo de trabalho ou as chances de um prisioneiro cometer novos crimes para conceder ou não uma liberdade condicional. Não existem sentimentos quando uma tecnologia dessas decide que é melhor demitir um professor premiado pois critérios arbitrários consideraram que ele não agregava valor aos alunos ou quando um administrador de condomínios decide implementar câmeras e IAs como forma de vigiar as práticas dos moradores e garantir que eles cumpram as regras.

Esse tipo de prática não é exatamente desconhecida, principalmente para quem acompanha o noticiário de tecnologia, mas sua extensão nem sempre é sentida — o que não significa que ela não exista. E é justamente ao demonstrar diferentes exemplos, um de cada vez, pertencentes a diferentes esferas da sociedade, desde classes altas e esclarecidas até a população mais carente, que está a grande problemática apresentada por Coded Bias e, também, o incômodo que só aumenta a partir daquela máscara branca que abre a exibição do documentário.

Quem vigia os vigilantes?

Outro pilar da produção é a escolha bem acertada de fontes, principalmente aquelas que saíram do mundo acadêmico para uma atuação real. Uma das personagens reais principais é Joy Buolamwini, cientista de computação do MIT (Instituto de Tecnologia de Massachusetts) que criou o conceito da máscara branca ao ver que os algoritmos de reconhecimento facial de código-aberto não eram capazes de identificar sua pele negra.

Foi a partir daí, das apresentações sobre preconceito tecnológico e das interações com Deborah Raji, outra cientista estudando a mesma questão, que surgiu a Liga da Justiça Algorítmica. A partir de um estopim acendido pela matemática americana Cathy O’Neil, especialista em ciência de dados, veio o grupo ativista que, até hoje, luta por políticas públicas contra a discriminação tecnológica e sistemas enviesados, já tendo, inclusive, conseguido algumas vitórias na esfera política dos Estados Unidos, com direito a um projeto de lei que espera banir os sistemas de reconhecimento facial do país.

O caminho foi longo e nada fácil como mostra outra expoente da luta contra a discriminação por algoritmos, Silkie Carlo, diretora da organização britânica Big Brother Watch. As manifestações contra o uso indiscriminado de sistemas de reconhecimento facial ganham contornos diretamente palpáveis quando um jovem negro é abordado e permanece sob averiguação policial durante mais de 15 minutos, diante das câmeras do documentário e dos olhares dos ativistas. Ele havia sido identificado erroneamente como um criminoso foragido pelo software das autoridades londrinas.

A hora e meia de Coded Bias é impactante e estarrecedora, principalmente pela ideia de que todos estamos submetidos a tais controles, ainda que a gente não perceba. Por outro lado, existe certa incidência em partir para o campo das ideias e fazer suposições, focando exageradamente em um “e se” que soa exagerado quando, como dito, existem inúmeros exemplos demonstrando que essa distopia pode ser mais real do que a gente imagina.

Aprender com situações desse tipo, que poderiam ser minhas ou suas, serve como grande potencializador do ponto a ser passado pelo documentário, que vai além apenas dos pedidos de regulação. A ideia é que o uso de algoritmos deve seguir princípios éticos e seus criadores precisam ser responsabilizados pelo funcionamento das tecnologias, que devem servir para o aumento no acesso e para facilitar atividades cotidianas ou burocráticas, e não, como a maioria dos exemplos mostra, como uma forma de fechar ainda mais portas.

Mais do que isso, é interessante notar como, com exceção da vigilância ostensiva usando reconhecimento facial, as fontes do documentário não se opõem necessariamente ao uso dos algoritmos, mas sim à maneira com a qual tais sistemas são utilizados hoje em dia. Muitas das proponentes vêm diretamente do mundo da tecnologia e, sendo assim, dedicam seus trabalhos a tornarem estes avanços melhores e mais inclusivos.

É claro, como um documentário que fala de vieses, Coded Bias também tem o seu próprio. Isso aparece, principalmente, no comentário altamente problemático e nada explorado sobre a diferença de transparência entre a vigilância ostensiva e o sistema de crédito social do governo chinês e o foco comercial dos algoritmos americanos. É um elemento que merecia um pouco mais de atenção, mas acaba sendo deixado de lado para uma absurdez que está mais próxima de nós.

Da mesma forma, soam assombrosos os comentários que aparecem ao final do documentário defendendo, justamente, a política digital chinesa. Ao contrário de todas as pesquisadoras, cientistas e políticas que aparecem ao longo do documentário, esta não é uma personagem creditada, acabando por finalizar a exibição com uma sensação esquisita de vazio, mas também, de que algo está errado com o próprio desfecho do documentário, como se todas as situações amplamente reais apresentadas já não fossem assustadoras o suficiente.

Na maior parte do tempo, porém, Coded Bias mantém um estilo direto e claro, o que explica a aclamação do documentário, vencedor de prêmios em festivais internacionais e que, agora, chega a todo o mundo por meio da Netflix. A escolha, inclusive, é curiosa, com a disponibilização acontecendo, justamente, em um serviço que depende fortemente dos algoritmos para não somente indicar conteúdo, mas também determinar o que é produzido ou não.

Coded Bias foi dirigido por Shalini Kantayya, de Breakthrough e Catching the Sun. O documentário estreou na Netflix em 5 de abril de 2021.