Google I/O | Google prepara IA que enxerga o mundo e interage com ele

Por Bruno De Blasi | Editado por Douglas Ciriaco | 14 de Maio de 2024 às 15h21

O Google apresentou o protótipo de um assistente de inteligência artificial (IA) que promete acompanhar você no dia a dia e enxergar o mundo pela câmera do seu celular. Parte do chamado "projeto Astra", a tecnologia foi revelada nesta terça-feira (14) e oferece orientações através de diversas interações, como câmera, comandos de voz e toques na tela.

- Como usar a IA Gemini do Google | Guia Prático

- Gemini Advanced x ChatGPT Plus | Qual o melhor serviço pago de IA?

O anúncio aconteceu durante a exposição do CEO do Google DeepMind, Demis Hassabis, no Google I/O 2024. Apesar da antecipação, ainda não há uma data para os agentes universais serem apresentados ao público em geral.

Assistente de IA poderosa

Segundo o executivo, o projeto para desenvolver agentes universais de IA faz parte “da missão do Google DeepMind de construir IA de forma responsável para beneficiar a humanidade”. A ideia, nesse caso, é oferecer uma ferramenta extra às pessoas, para auxiliá-las em tarefas do dia a dia ao interagir com o ambiente ao redor do usuário.

“Para ser verdadeiramente útil, um agente precisa compreender e responder ao mundo complexo e dinâmico, tal como as pessoas fazem – e absorver e lembrar o que vê e ouve para compreender o contexto e agir”, observou o executivo. “Ele também precisa ser proativo, ensinável e pessoal, para que os usuários possam conversar com ele naturalmente e sem atrasos.”

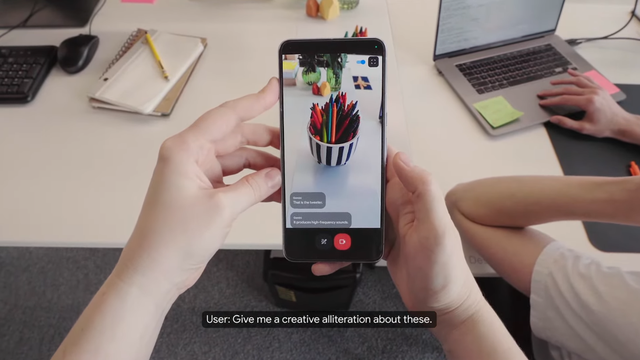

Parte desse avanço foi demonstrado em um vídeo, que abre com a câmera de um celular aberta em um escritório. Em seguida, a interlocutora faz perguntas por comando de voz, como “me mostra algo que faz som” e o Gemini mostra onde há uma caixa de som.

Ao se aproximar do objeto, outra pergunta é feita: “como essa parte da caixa de som é chamada?”. Mas, dessa vez, uma seta é desenhada na tela para indicar o objeto desejado e, sem delongas, o assistente responde: “isso é um tweeter” e explica a sua serventia.

Em outros momentos, o assistente de IA auxilia em outras frentes. É o caso da leitura de um código de programação com a câmera para indicar a função das linhas apresentadas. Durante o vídeo, a interlocutora também vira o celular para a janela e pergunta em que bairro ela está — nos dois casos, o agente responde com agilidade e precisão.

O assistente pode ser utilizado através de outros dispositivos, como os óculos inteligentes. Dessa vez, o agente foi usado tanto para identificar informações e dar sugestões, sejam elas técnicas ou criativas.

Agente foi construído a partir do Gemini

O protótipo antecipa os planos do Google para tecnologias de inteligência artificial. Ao mesmo tempo, mostra a capacidade de sistemas existentes, como é o caso do Gemini, já que a solução foi criada a partir do modelo da empresa.

“Esses agentes foram construídos em nosso modelo Gemini e em outros modelos específicos de tarefas, e foram projetados para processar informações mais rapidamente, codificando continuamente quadros de vídeo, combinando a entrada de vídeo e fala em uma linha do tempo de eventos e armazenando essas informações em cache para uma recuperação eficiente”, explicou Hassabis.

Contudo, ainda pode levar um tempo para que todos esses elementos sejam liberados ao público. O executivo afirmou, durante a apresentação, que “alguns desses recursos chegarão aos produtos do Google, como o aplicativo Gemini, ainda este ano”, sem oferecer uma data específica.