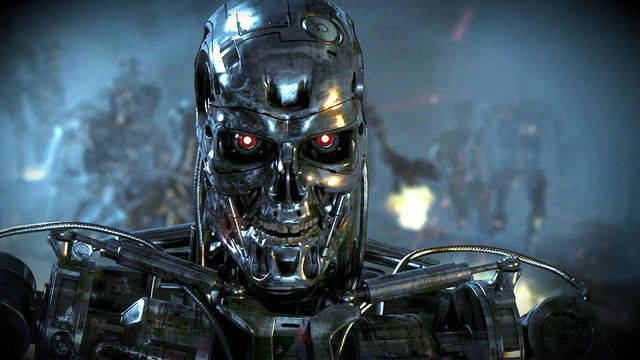

OpenAI forma time para evitar apocalipse causado por IA

Por Guilherme Haas | Editado por Douglas Ciriaco | 27 de Outubro de 2023 às 17h40

A OpenAI, empresa responsável pelo ChatGPT, anunciou a formação de uma equipe para evitar possíveis cenários apocalípticos decorrentes da atividade de modelos de inteligência artificial. O novo time terá a missão de avaliar a possibilidade de catástrofe com ameaças químicas, biológicas, nucleares e em cibersegurança.

Essa equipe recebeu o nome de “Preparação” e vai “rastrear, avaliar, prever e proteger” contra possíveis riscos, informa o comunicado da empresa em seu site.

Riscos da IA

Segundo a OpenAI, os modelos de IA “de ponta”, que vão exceder a capacidade dos modelos existentes no mercado, têm o potencial de beneficiar toda a humanidade, mas também “representam riscos cada vez mais graves”.

Com essa preocupação em vista, o novo time de “Preparação” vai elaborar um material sobre os riscos envolvendo a tecnologia, com a apresentação de ações de proteção e uma estrutura de governança para responsabilizar os sistemas de IA.

Esse material deverá responder a algumas perguntas sobre a segurança dos novos modelos, são elas:

- Quão perigosos são os modelos de IA quando mal utilizados, tanto agora quanto no futuro?

- Como podemos construir uma estrutura robusta para monitoramento, avaliação, previsão e proteção contra as capacidades perigosas dos sistemas de IA de fronteira?

- Se os modelos de IA de ponta fossem roubados, como os agentes mal-intencionados poderiam aproveitá-los?

No site da OpenAI, é possível se candidatar para vagas no time de “Preparação”, com trabalho em São Francisco, EUA, e salários entre US$ 200 mil e US$ 370 mil por ano.

Preocupações com IAs mal-intencionadas

No último ano, diversos pesquisadores e desenvolvedores envolvidos com os últimos avanços inteligência artificial expressaram preocupação sobre os perigos que a tecnologia representa.

Em fevereiro, o CEO da OpenAI, Sam Altman, já pedia a regulamentação da tecnologia para evitar IAs “potencialmente assustadoras”. Em março, diversos especialistas — incluindo o bilionário Elon Musk — solicitaram uma interrupção no treinamento de modelos para criar protocolos de segurança e auditoria sobre as IAs.

No mês de julho, gigantes do setor de tecnologia — incluindo Google, Microsoft, Anthropic e OpenAI — anunciaram a criação de grupo de pesquisa para entender riscos e estabelecer boas práticas no desenvolvimento da tecnologia.

Já nesta última semana, o Google ampliou o seu programa de recompensas por descoberta de vulnerabilidade para incluir o pagamento pela identificação de riscos em sistemas de inteligência artificial.

No seu anúncio, a Big Tech de Mountain View também expressa a preocupação que os modelos e algoritmos podem ser usados por pessoas mal-intencionadas e provocar grandes estragos.