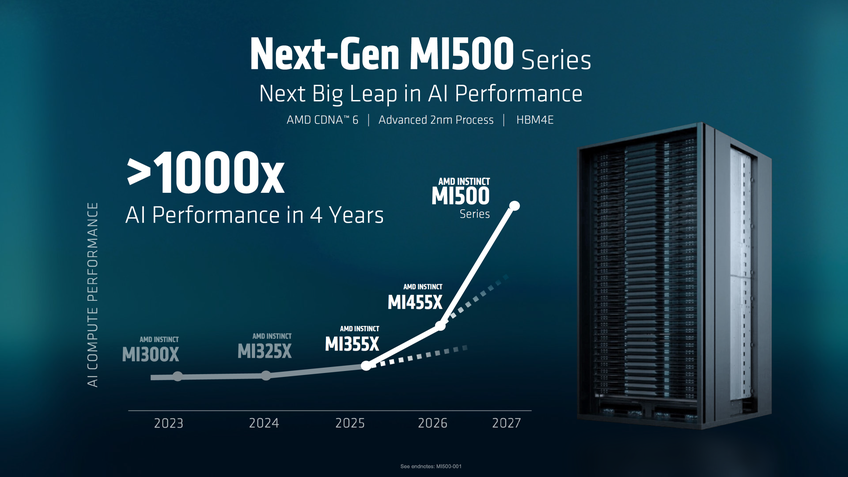

AMD promete 1.000x mais desempenho em IA com GPUs Instinc MI500 em 2027

Por Raphael Giannotti |

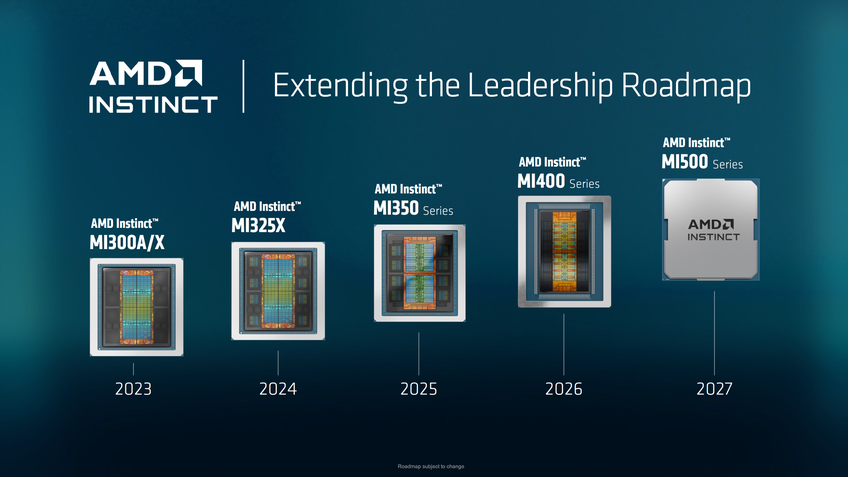

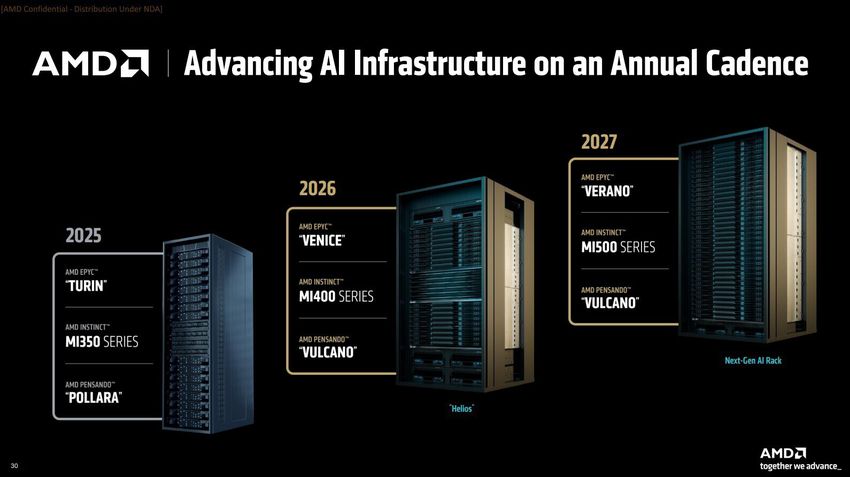

A CES 2026 chega ao fim nesta sexta-feira (9) e todos os grandes anúncios já foram feitos no início da semana e não seria exagero dizer que a feira foi sobre inteligência artificial. Assim como a NVIDIA e a Intel, a AMD também trouxe diferentes novidades para esse segmento, como as novas gerações de aceleradoras de IA com a série Instinct MI400 que chega esse ano, além de revelar que a geração seguinte trará aumento de desempenho 1.000x maior já no ano que vem.

- Quando surgiu a inteligência artificial? Conheça a história da IA

- CES 2026: IA vai além da tecnologia e vira a ‘espinha dorsal’ da inovação

Usando as novas memórias HBM4 (uma das causadoras da crise de DRAM por conta da grande demanda), e a arquitetura CDNA 5, a série MI400 chega ainda em 2026 para atender a demanda da indústria de IA por mais poder computacional. Porém a AMD promete elevar muito mais o nível em 2027 com as GPUs MI500, chegando a 1.000 vezes mais performance em relação às atuais GPUs MI300.

GPUs Instinct MI500 parecem do futuro, mas chegam em 2027

Segundo a AMD, a futura Instinct MI500 será baseada em uma litografia avançada de 2nm da TSMC, permitindo uma densidade de transistores sem precedentes. O salto geracional acontecerá através da nova arquitetura CDNA 6, projetada especificamente para lidar com modelos de linguagem gigantescos que as empresas de tecnologia almejam treinar nos próximos anos. A série MI500 promete inaugurar a era dos Yottaflops (1.000 Zettaflops ou um milhão de Exaflops) em data centers, uma métrica de desempenho que até pouco tempo parecia ficção científica.

"Com o lançamento do MI500 em 2027, estamos a caminho de proporcionar um aumento de 1000 vezes no desempenho da IA nos últimos quatro anos, tornando uma IA mais poderosa acessível a todos", disse Lisa Su, CEO da AMD, em sua apresentação.

Para alimentar todo esse processamento, a AMD vai adotar a memória HBM4e (uma evolução da HBM4 que veremos este ano). A largura de banda proporcionada por essa tecnologia é essencial para que os núcleos da GPU não fiquem ociosos esperando dados. Isso é crítico, especialmente considerando que a escassez de memória de alta largura de banda tem sido o principal gargalo para o avanço da IA generativa.

A apresentação detalhou ainda o conceito do UAL256 Mega Pod, uma infraestrutura de grande escala que pode agrupar até 256 GPUs MI500 trabalhando juntas. Para gerenciar todo esse fluxo de dados, a AMD introduziu os novos processadores de codinome "Verano". Cada Mega Pod integrará 64 dessas CPUs, criando um ecossistema coeso onde CPU e GPU compartilham memória e recursos de forma mais eficiente do que nunca, desafiando diretamente as soluções integradas da NVIDIA.

Veja mais do CTUP:

- NVIDIA lança chip BlueField-4 para dar "memória de longo prazo" à IA

- AMD apresenta mini-PC com 128 GB de memória para rodar IA localmente

- Intel declara guerra à AMD nos portáteis e promete até 75% mais desempenho