IA moderadora do Facebook confundiu vídeo de tiroteio com lavagem de carro

Por Alveni Lisboa | Editado por Douglas Ciriaco | 18 de Outubro de 2021 às 13h12

A maior parte do trabalho de moderação nas redes sociais é feito pelos algoritmos alimentados por inteligências artificiais especificamente projetadas para executar ações como bloquear determinados tipos de conteúdo e enaltecer outros. O Facebook tem essa promessa desde novembro de 2018 e, de fato, tem lutado para implementá-la, embora ainda falte refinamento para que tudo funcione com mais precisão.

- Facebook explica quais conteúdos são flopados no feed e como não ser penalizado

- Facebook e Microsoft se juntam a banco de dados para coibir grupos extremistas

- Facebook visa o lucro acima de tudo, acusa ex-funcionária; Zuckerberg se defende

Até março de 2021, documentos internos da rede obtidos pelo Wall Street Journal revelaram que as ferramentas automatizadas de moderação só foram responsáveis por remover entre 3% e 5% de vídeos com discurso de ódio e apenas 0,6% dos materiais com violência. Embora possa parecer pouco, a plataforma afirma ter removido 15 vezes mais conteúdos com eficácia em 2020 do que em 2017, uma prova da evolução do modelo, mas ainda longe da prometida eficácia.

Os documentos também mostraram como a IA confunde coisas simples para qualquer ser humano: brigas de galos, por exemplo, foram erroneamente sinalizadas como um acidente de carro, enquanto vídeos ao vivo de tiroteios em massa foram rotulados pela IA como jogos de paintball ou uma ida a um lava à jato. Isso ocorre porque a máquina tenta associar elementos do vídeo com sua base de dados, o que obviamente nem sempre dá certo.

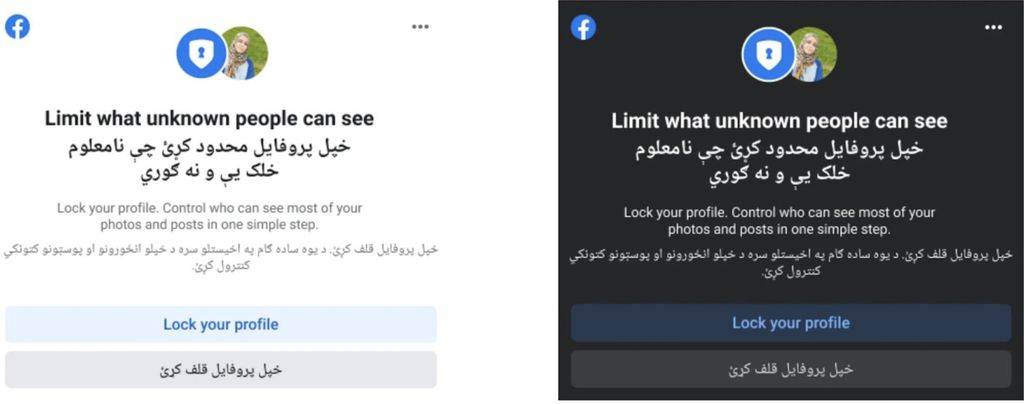

Essas confusões citadas teriam ocorrido com conteúdos na língua inglesa, a mais falada no mundo, mas pode ser ainda pior em outros idiomas. O relatório obtido apontou a falta um dicionário de termos "proibidos" para os idiomas falados no Afeganistão, razão pela qual a IA só conseguiu identificar 0,23% dos discursos de ódio no país.

Haverá um platô

Os números ainda podem melhorar bastante é claro, mas devem atingir um teto em algum momento no qual novos avanços serão difíceis, conforme o relato de um engenheiro sênior da empresa em 2019. Na avaliação de um especialista do próprio Facebook, eles não têm e provavelmente nunca terão um modelo único capaz de capturar todas as nuances necessárias para classificar um vídeo, especialmente em áreas mais sensíveis — no curto e médio prazo, o percentual não deverá ultrapassar 20%.

Os dados são obtidos a partir da amostragem de materiais específicos sobre os quais as ferramentas de moderação de IA são aplicadas e depois comparados com a ação dos humanos. Com base na quantidade de acertos, dá para mensurar quanto de discurso de ódio ou outras práticas foram corretamente banidas, quantas foram classificadas de modo errado e os casos omissos.

Essa parece ser uma abordagem científica bastante válida e revela um bom ceticismo da rede quanto as suas ferramentas, embora não deixe transparecer para o público. Em declarações públicas, o Facebook divulgou a porcentagem de discurso de ódio descoberto pela IA antes que os usuários relatassem de 98%, o que provavelmente é verdadeiro, já que existem muitos casos não denunciados.

Um porta-voz da empresa, Andy Stone, disse ao The Wall Street Journal que os números sobre postagens removidas não incluem outras ações realizadas, como diminuir o alcance de conteúdo suspeito. Então, na prática, não seria necessário apenas excluir os materiais, porque as pessoas simplesmente deixariam de vê-lo.

Lucro e redução de custos

A remoção automatizada não é apenas uma questão de praticidade, mas impacta também no lucro da empresa, afinal os moderadores humanos custaram US$ 104 milhões em 2019, conforme a apuração do jornal estadunidense. Cerca de 75% desses funcionários tinha o único objetivo de responder aos relatórios de denúncias encaminhados por usuários e impusesse uma meta de reduzir em até 15% o custo total das operações.

O WSJ acusa a rede de ter manipulado o algoritmo àquela altura para ignorar os relatórios do usuário no intuito de contribuir para essa redução. Ademais, o botão de denunciar antes visível em qualquer post ficou mais "escondido" propositalmente para tornar a tarefa um pouco mais complexa.

Os relatórios revelaram que o usuário do Facebook prefere a adoção de uma abordagem mais proativa para fazer cumprir as violações da sua política de conteúdo, mesmo que para isso posts legítimos sejam excluídos no processo. As remoções imprecisas teriam sido apontada como uma preocupação muito menor quando comparada à violência e outras violações.

Apesar disso, segundo o jornal, daqui para frente, o Facebook deve concentrar seus esforços em treinar modelos para evitar falsos positivos, mesmo que para isso seja preciso permitir que mais discursos de ódio passem batidos. O jeito é acompanhar e torcer para que a IA consiga fazer ambos com a eficácia esperada, afinal todos ganham com um ambiente mais leve, sadio e seguro.

Fonte: Wall Street Journal, Facebook [1] e [2]