Modelos pré-treinados NVIDIA NIM vão acelerar deploy de IA

Por Daniel Trefilio | Editado por Jones Oliveira | 20 de Março de 2024 às 14h21

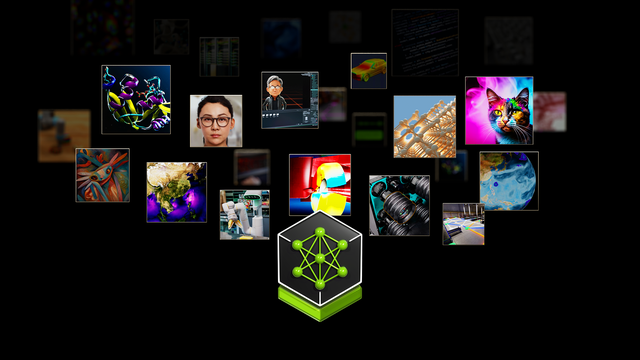

A NVIDIA apresentou durante a GTC 2024 o NVIDIA Inference Microservices (NIM), pacote de modelos de inferência pré-treinados para acelerar a implantação de IA em grande escala. Em sessão de Perguntas e Resposta, o CEO da NVIDIA, Jensen Huang, afirmou que a IA não está no hardware, mas no software; o hardware é apenas projetado para viabilizar as aplicações idealizadas.

O NIM é parte da abordagem full-stack da NVIDIA de fornecer o ecossistema completo necessário para que empresas de todos os tamanhos não apenas implementem IAs prontas, mas criem suas próprias, adaptadas sob medida para suas necessidades. Diferente de escolher APIs de desenvolvimento específicas, o NIM permite experimentar com uma série de plataformas abertas, todas otimizadas para CUDA em parceria direta entre as desenvolvedoras e a NVIDIA, e baixar o modelo que mais se adequada à demanda de cada cliente.

Liberdade de escolha e facilidade de migração

Os microsserviços de inferência NVIDIA incluem modelos para diversos setores, entre empresas de saúde, análise de imagens, assistentes virtuais de IA a desenvolvimento de jogos. Na prática, os modelos reduzidos pré-treinados estão todos disponíveis em formato aberto para as corporações experimentarem tanto em ambientes de nuvem quanto em seus sistemas internos.

Como todos já são otimizados para CUDA, tecnicamente qualquer infraestrutura NVIDIA consegue operá-los, permitindo ao menos entender quais desses modelos se aplicam melhor às necessidades da empresa. Além disso, por estarem todos inclusos no pacote NVIDIA AI Enterprise, a própria NVIDIA se encarrega de dimensionar o tamanho da infraestrutura necessária para operar aqueles serviços, e direcionar o cliente para a fabricante parceira com as soluções mais adequadas.

Outra vantagem é que o suporte nativo dos produtos inclusos no NIM ao hardware NVIDIA permite simplesmente trocar o modelo, caso um inicial não esteja performando como desejado. Basta o cliente baixar o novo modelo e retreiná-lo internamente, utilizando praticamente os mesmos processos do produto anterior.

Além de otimizar o dimensionamento de custo de operação de IA, evitando investir mais recursos do que o estritamente necessário, segundo a NVIDIA, essa abordagem reduz o tempo de implantação de meses para semanas.