Sociedade pode estar perdendo a guerra contra os deep fakes, alerta professor

Por Felipe Demartini | 08 de Outubro de 2020 às 19h00

As fake news evoluíram de simples informações falsas ou recortes mentirosos da realidade para algo muito maior e, principalmente, bem mais perigoso. Imagine ver sua própria imagem, com direito a trejeitos de fala, postura e até cacoetes, reproduzidos em vídeo, mas em uma situação da qual jamais participou, proferindo palavras que nunca disse? Com os deep fakes, isso é possível, e mais do que isso, uma realidade em um mundo cada vez mais polarizado.

- O que é deepfake e como ela funciona?

- Fake news: como você lida com este fenômeno?

- 5 sites para checar se a notícia é verdadeira ou falsa

Principalmente quando levamos em conta um estudo conduzido pela Universidade da Califórnia, Berkeley, nos Estados Unidos, que concluiu que uma manipulação desse tipo pode ser, muitas vezes, indistinguível da realidade. A pesquisa foi conduzida pelo professor Hany Farid, ao lado da estudante de graduação Shruti Agarwal, e concluiu que, quando analisados os dados, há mais semelhanças do que diferenças entre uma imagem real e outra falsa.

A pesquisa criou um modelo multidimensional de vídeos publicados na internet retratando nomes importantes da política como Barack Obama, Donald Trump e outros. Um algoritmo analisou diferentes características do discurso em si, entonação e volume da voz, assim como maneirismos, tiques e manias de cada um dos retratados, de forma a criar um mapa visual do “jeito” de cada um deles.

A surpresa foi que, em muitos dos casos, a imagem pertencente à figura real, muitas vezes, se misturou às criadas a partir de manipulações, gerando um resultado que, se é capaz de confundir às máquinas, imagine aos seres humanos. O resultado, segundo Farid, é um combate desbalanceado, que usa elementos de desinformação e se aproveita da atual polarização gerada pelas redes sociais para criar um panorama bastante negativo no qual quem perde é a sociedade.

“Os desenvolvimentos de sistemas [de inteligência artificial] e a velocidade de disseminação são mais rápidos do que a análise destes conteúdos”, explica, durante uma palestra no evento CyberSec & AI Connected, promovido nesta semana pela Avast. “Os moderadores e as autoridades estão sempre correndo atrás”, completa o professor.

Problema renovado

Farid aponta, por outro lado, que as manipulações digitais de imagens não são uma novidade, pelo contrário, existem desde os anos 1990 e surgem junto com a evolução dos softwares gráficos. O que começou na forma de alterações visuais de imperfeições ou até mudanças diretas no discurso, entretanto, evoluiu para algo muito mais perigoso, enquanto a relação das pessoas com as imagens se manteve inalterada.

Na visão do especialista, os indivíduos sempre estiveram cientes de que imagens podem ser manipuladas e que, ao saírem do mundo, passando através de uma câmera e, depois, por softwares como o Photoshop, elas ainda são, em maior ou menor grau, uma reprodução da realidade. O problema, segundo ele, começou quando a inteligência artificial evoluiu ao ponto de criar farsas completas, que vêm sendo utilizadas para fins nada positivos.

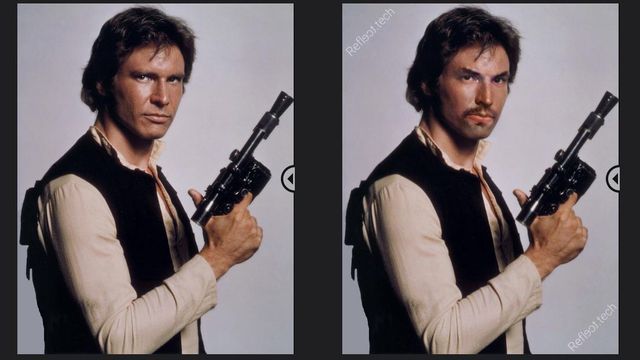

Ele cita, por exemplo, os sistemas de deep learning capazes de criar rostos com aparência real, mas que não pertencem a pessoas de verdade. Tais plataformas usam uma tecnologia chamada de Rede Geracional Adversarial, que funciona, basicamente, em duas etapas: na primeira, o algoritmo gera uma imagem humana que julga verossímil, enquanto uma segunda IA, com base em fotos reais, avalia se a foto realmente passaria como a de um ser humano. Caso contrário, todo o processo é recomeçado, com o resultante sendo as imagens que passarem com sucesso pelos dois crivos virtuais.

O mesmo processo também é usado na criação dos deep fakes, de forma que a transposição do rosto de uma pessoa para o corpo de outra aconteça, também, da forma mais natural possível. E assim como as fotografias de pessoas que não existem, no caso de um resultado bem feito, podem ser usadas de forma altamente danosa. “Estamos vendo uma verdadeira armamentização das [imagens falsas], que podem ser usadas para atingir a imagem dos indivíduos reais, manipular a opinião pública ou praticar crimes”, afirma Farid.

Ele cita diferentes exemplos durante sua apresentação, com a pornografia não consensual sendo a mais popular. Segundo ele, a ideia vai além de colocar a aparência de celebridades em vídeos de sexo, se tornando muito mais danosa quando falamos de pessoas comuns, principalmente mulheres, que podem ser extorquidas ou difamadas para que as cenas, ainda que falsas, não sejam divulgadas.

Outro exemplo aparece nas campanhas de difamação, que podem usar as fotografias forjadas como arma política para colocar algo que nunca foi dito na boca de um político ou representante. Da mesma forma, verdadeiros exércitos de disseminação de conteúdo falso podem ser criados com o uso dos avatares de pessoas inexistentes, disseminando por aí mensagens como se pessoas reais estivessem por trás dos perfis.

O professor levanta, ainda, um ponto ainda mais grave, voltado ao sistema judiciário. Afinal de contas, como ele afirma, o público ainda não está plenamente ciente das consequências e métodos usados pelos fraudadores. “Como confiar, em um tribunal, nesse tipo de conteúdo que pode ser facilmente manipulado?”, pergunta, indicando também implicações relacionadas à segurança nacional como um aspecto a ser levado em conta.

Dois lados

Outro problema da sociedade atual se une a este, com a polarização gerada pelas redes sociais constituindo um ponto que leva as pessoas a estarem mais propensas a acreditarem em um deep fake caso ele passe uma mensagem que seja conveniente. “As pessoas querem acreditar no que estão vendo, seja por seus princípios políticos ou, simplesmente, pela forma como enxergam a realidade através de imagens”, afirma, indicando que isso vale, também, no sentido oposto, com imagens verdadeiras que podem ser dispensadas como se fossem falsas, com escândalos e denúncias sendo deixadas de lado enquanto os responsáveis se aproveitam do ambiente de incerteza.

Farid defende iniciativas de educação sobre os perigos dos deep fakes, para que os usuários entendam como nem tudo o que enxergam pode ser real, e de que forma discursos desse tipo podem florescer em um ambiente de polarização. O especialista também volta seus olhos às redes sociais e plataformas online, que considera responsáveis pelo atual clima de animosidade.

Ele faz uma proposta de regulamentação sobre o alcance dos discursos veiculados e pede que isso não se confunda com censura, uma vez que não se trata de trabalhar o que é dito, e sim, como isso é amplificado e chega aos ouvidos do público, com informações mentirosas e dados manipulados sendo veiculados ao lado da verdade e, agora, também dos deep fakes.

O Brasil aparece como um exemplo em que esse tipo de manipulação cria um ambiente de adversários, ao lado da Índia e dos Estados Unidos, que foi o foco da pesquisa feita em Berkeley. Assim como no restante do mundo, os deep fakes ainda não são amplamente explorados como uma arma em nosso país, o que levanta ainda mais, na visão do especialista, a importância da regulamentação sobre a forma como as redes sociais e tecnologias disseminam os discursos, antes que esse tipo de adulteração se torne mais popular.

“As plataformas não são neutras. Elas usam algoritmos para exibir conteúdo de acordo com a preferência dos usuários e isso acaba contribuindo para a polarização, uma vez só vemos o que o sistema julga ser conveniente”, completa Farid. Ele sugere medidas oficiais de responsabilidade corporativa também no que toca o funcionamento das plataformas e alerta que o tempo urge. Quanto mais o relógio corre, mais desfavorável a situação e mais perdida se torna a batalha.