Deepfakes no Brasil | Parte 3: Como se proteger dos vídeos falsos

Por Rafael Rodrigues da Silva | 03 de Novembro de 2019 às 14h36

Fake news, o grande mal da internet nos últimos cinco anos e que não deve sumir tão cedo. A popularização das redes sociais tornou esses lugares um terreno fértil para o surgimento e compartilhamento de notícias falsas e, com os avanços da tecnologia, tudo isso promete ficar ainda mais complicado com os deepfakes.

Baseado em um relatório publicado pela WITNESS, uma organização global que apoia o uso de tecnologias audiovisuais para a defesa dos direitos humanos, iremos publicar uma série de reportagens especiais sobre fake news, o que são deepfakes, como elas podem ser usadas para complicar ainda mais um cenário já caótico e o que podemos fazer para nos proteger dessa nova tecnologia.

Na primeira parte do especial, falamos sobre o estado em que se encontram as fake news no Brasil em 2019, e na segunda parte entramos em mais detalhes sobre o que são exatamente as deepfakes. Agora, na terceira e última parte deste especial, falaremos um pouco sobre como reconhecer um deepfake.

Enfrentando os deepfakes

Agora que já sabemos o que é um deepfake e qual o perigo que eles oferecem em um mundo cada vez mais conectado pelas redes sociais (caso você não tenha lido as duas primeiras partes deste especial, recomendamos que dê uma olhada nelas para entender melhor o que iremos falar por aqui), a grande pergunta que deve ser respondida é: o que fazer para evitar que esses conteúdos se tornem uma ameaça real para a sociedade?

A primeira coisa que se deve fazer é esquecer todas aquelas “verdades definitivas” sobre como reconhecer um deepfake. Um exemplo disso é de uma dica que percorreu as redes sociais no ano passado, sobre uma pesquisa que explicava como era simples reconhecer um deepfake apenas prestando atenção nos olhos, já que os rostos inseridos de forma digital não piscavam — apenas para, duas semanas depois desse estudo ser publicado, surgir o primeiro deepfake com um rosto que pisca.

O erro desse tipo de “técnica” para identificação é que ela se foca no problema de um único algoritmo, ao invés de em algo que pode ser comum para todos. Sim, durante muito tempo os algoritmos mais usados para a criação de deepfakes não conseguiam fazer o movimento de piscar dos olhos nos rostos inseridos digitalmente. Mas, assim como qualquer algoritmo baseado em deep learning, ele vai se atualizando sozinho conforme é usado e mais objetos (vídeos e fotos) são colocados em sua base de dados, e por isso esse tipo de erro tende a se corrigir com o próprio uso. Esse é o motivo de esses “erros claros” não poderem ser considerados como uma regra geral e irrestrita para se decidir se um vídeo é ou não um deepfake.

Por isso, a primeira recomendação dos especialistas para conter a ameaça dos deepfakes é tornar esses vídeos os mais populares possíveis. A sugestão pode parecer contraditória a princípio, principalmente se pensarmos que o objetivo é para evitar que o uso se torne comum. Mas, em 2019, é preciso pensar o contrário, pois tentar esconder e ignorar algo não irá impedi-lo de se popularizar — principalmente uma tecnologia como a deepfake, capaz de realizar trabalhos extremamente complexos para manipular a opinião pública.

Por isso, a melhor forma de evitar que essa tecnologia crie estragos na sociedade não é criando forma de escondê-la, mas sim revelando que tal conteúdo se trata de um deepfake, e acostumando as pessoas a verem vídeos que utilizam a técnica. Neste caso em especial, o uso para humor feito por artistas como Bruno Sartori é extremamente importante, pois ajuda o público a se familiarizar com essa técnica de modo mais “leve”, facilitando a compreensão de que o deepfake não é nenhum “demônio”, mas apenas algo que fará parte da vida de todos nos próximos anos.

A ideia usa como base lógica o fato de que é o desconhecimento que nos faz acreditar que uma manipulação digital é real, e assim que aceitamos que esse tipo de manipulação digital existe, é mais fácil ficarmos mais atentos e não nos tornarmos vítimas dela. Extrapolando um pouco essa lógica, é algo parecido com a introdução do cinema: uma história famosa é que, na projeção pública de um filme, o pessoal que assistia saiu correndo na hora que um trem apareceu na tela, pois acharam que era um trem real que estava vindo de encontro a eles. Logo que essa tecnologia foi divulgada e explicada para as pessoas, não houve mais confusões.

Outra saída é a utilização de “intervenções invisíveis” em nossas fotos e vídeos — basicamente, seria fazer com que essas imagens passassem por um processo que insere uma espécie de código nelas que não faz nenhuma modificação naquilo que o olho humano enxerga, mas que impede que os algoritmos de criação de deepfake consigam escanear seu rosto para inseri-lo digitalmente em outro vídeo. Ainda que seja uma saída para evitar que pessoas comuns sejam vítimas de golpes usando deepfakes, isso exigiria que todos os locais onde você publica sua imagem (como as redes sociais, o YouTube ou aplicativos como Snapchat) invistam continuamente em ferramentas atualizadas que criem essas “intervenções invisíveis” em todas as mídias de imagem postadas por qualquer usuário, obrigando essas empresas a desembolsarem, provavelmente, alguns milhões de dólares para que essa implementação ocorra. Mesmo que isso aconteça, ainda não deverá servir para proteger figuras públicas contra a criação de deepfakes políticas, já que esses processos são mais complicados de se efetuar em imagens transmitidas ao vivo (como debates, discursos e comícios) pois seria necessário o uso de computadores extremamente potentes para que esse processamento da imagem fosse feito sem gerar um grande delay na transmissão.

Outra possível saída tecnológica é a utilização de blockchain integrada a outros mecanismos como forma de autenticar a fonte real de uma publicação sem precisar quebrar a privacidade dos usuários (de forma idêntica ao que acontece hoje nas transações envolvendo bitcoins e outras criptomoedas). Assim, caso um vídeo falso seja compartilhado e viralize nas redes sociais, seria possível rapidamente rastrear qual sua origem e quem é o verdadeiro autor daquele conteúdo, permitindo assim uma rápida exposição da obra como falsa e a remoção do conteúdo. Mas, assim como o software de inserção de “intervenções invisíveis”, essa solução também exigiria um certo investimento em infraestrutura pelas empresas de mídia que atuam na internet, o que significa que também é uma solução que não será implementada sem resistência da parte delas.

Ferramentas contra deepfakes

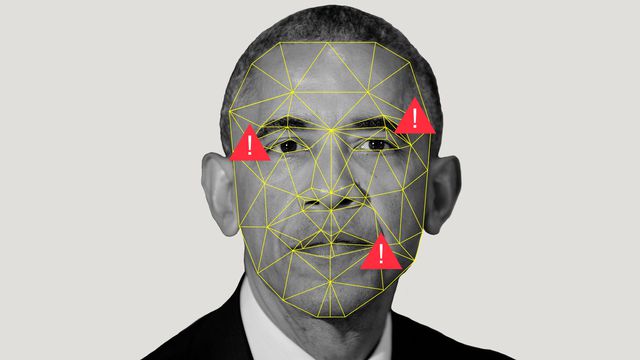

Reconhecer um deepfake, principalmente se você não é um profissional do audiovisual, não é nada fácil. Por conta da própria forma como o algoritmo de criação de deepfakes funciona, é extremamente complicado reconhecer vídeos falsos criados por modelos de IA avançados. Mas existem alguns modos de descobrir se o que você está assistindo é real ou não.

O melhor método de se detectar uma deepfake é o mesmo usado para se criar esses vídeos falsos: utilizar uma IA. Assim como se desenvolveram algoritmos para a inserção digital de rostos e pessoas de forma extremamente realista em vídeos onde elas não estão presentes, também é possível que a IA faça a engenharia reversa dos algoritmos de criação de deepfakes para desenvolver um programa capaz de reconhecer quando um vídeo foi manipulado digitalmente.

Atualmente, existem três técnicas que são usadas para criar esse tipo de programa: a primeira delas é a análise de luzes, que é talvez uma das melhores formas de se reconhecer um deepfake. Isso porque é praticamente impossível que o vídeo de origem e o vídeo destino utilizem exatamente a mesma fonte de luz. Essa análise pode ser feita criando-se um mapa de iluminantes (basicamente, um perfil de onde estão posicionadas as fontes de luz da imagem) e então rastreando a direção dos raios de luz, procurando pontos onde eles refletem ou se propagam em direções que não condizem com o tipo de material que esses raios de luz estão iluminando.

Outros tipos de programas que podem ser usados para esse combate seria a criação de um algoritmo de filogenia múltipla (uma IA que consegue identificação cronológica e derivada de imagens e vídeos, podendo identificar quais foram as imagens e vídeos usadas para se criar a deepfake) ou ainda um algoritmo que detecta o “estilo” do vídeo (parecido com o que já é usado para identificar a escrita de bots no Twitter). Mas, ainda que todos esses caminhos sejam possíveis, todos eles possuem problemas e nenhum é uma solução definitiva para se identificar um deepfake até agora.

O “calcanhar de Aquiles” dessas técnicas é o fato de todas elas serem limitadas à sua base de dados. Como a maioria dos algoritmos de IA, será preciso “treinar” esses programas, inserindo vídeos reais e falsos em seus bancos de dados para que o algoritmo possa analisá-los e, assim saber o que procurar em um vídeo para identificar se ele é falso. Assim, o algoritmo de identificação é limitado pela base de vídeos usada para treiná-lo, e qualquer deepfake que utilize alguma técnica que não conste no banco de dados da IA de reconhecimento será considerado real, gerando um falso negativo.

Mesmo a técnica de análise da luz não pode ser considerada como a “técnica definitiva”. Isso porque um programa que faça esse tipo de análise dos pontos de iluminação e da direção da luz simplesmente irá perder toda sua utilidade assim que o algoritmo para criação de deepfakes evoluir e passar a considerar não apenas os pontos de contato com o rosto, mas também a iluminação do ambiente.

Assim, mesmo utilizando as mais avançadas tecnologias, a briga será "eterna" e talvez nunca exista uma ferramenta infalível para a detecção das deepfakes, pois a própria natureza de existência delas envolve se aprimorar cada vez.

Mas e agora, como se proteger das deepfakes?

Não há uma forma infalível de se detectar se um vídeo é falso ou não, mas existem diversos comportamentos que você pode tomar para evitar de ser vítima de um deepfake.

A primeira dica é prestar atenção em detalhes como o movimento dos cabelos, da boca e dos olhos. Ainda que já existam algoritmos que conseguem deixar esses elementos os mais naturais possíveis, não existe um único programa que é usado para a criação de deepfakes, e por isso essa qualidade com os detalhes pode variar. É bom ficar de olho nesses detalhes do vídeo, pois se eles se comportarem de maneira estranha (por exemplo, o o cabelo ficar estranhamente fixo enquanto a cabeça se mexe, os olhos não piscarem ou a boca parecer fora de sincronia com o que realmente está sendo falado) é um bom indício de que se trata de um vídeo falso.

Outra dica é sempre desconfiar de declarações que pareçam muito absurdas, principalmente quando falamos de vídeos políticos. Claro, isso não quer dizer que não existam declarações absurdas na política, mas, de modo geral, as figuras públicas costumam ter um certo decoro em seus pronunciamentos. Vale ter malícia: é preciso sempre desconfiar quando somos confrontados com uma informação extremamente positiva ou negativa.

Preste sempre atenção em qual é a fonte da informação. Muitas vezes, mesmo que diversos sites tenham replicado essa informação, ninguém sabe dizer exatamente de onde ela vem, citando apenas “encontrado nas redes sociais” ou “recebido por um grupo de WhatsApp” como fonte. Se esse for o caso, comece a desconfiar, pois quando algo não tem uma fonte definida, há uma grande chance de ser mentira.

É importante também prestar atenção para não ser enganado por algo que nem tinha essa intenção. Por exemplo: nos últimos dias, o vídeo de um suposto robô militar fez bastante sucesso nas redes sociais como um exemplo dos perigos da tecnologia, mas tudo o que se precisava saber para notar que não se tratava de um vídeo real era olhar a “empresa” que criou o robô: a Bosstown Dynamics, um nome que parodia uma empresa de robôs real, a Boston Dynamics. Também é possível saber que não se trata de um robô real ao ver que o canal que postou o vídeo no YouTube foi o Corridor, conhecido e especializado na criação de vídeos para a internet usando técnicas de efeitos especiais equivalente às usadas nos filmes de Hollywood. Assim, o vídeo nunca foi uma tentativa de enganar ninguém (afinal, foi postado por um canal que deixa clara sua intenção), mas ao ignorar esse contexto, permitiu-se que o vídeo fosse compartilhado pelas redes sociais como se fosse real, o que acabou transformando um conteúdo inocente em fake news.

Uma boa dica também é fazer uma busca do tema no Google e prestar atenção em quais são os sites e veículos de imprensa estão falando sobre o tema. Caso tal tema esteja sendo ignorado pelos veículos maiores ou mais tradicionais (como os grandes portais de internet ou os grandes jornais e revistas que tratam daquele tema) e esteja sendo comentado apenas em fóruns como Reddit e 4Chan ou em blogs menores que não estão associados a nenhum veículo real de imprensa, a chance de aquilo que você viu ser falso é bem grande.

Até a imprensa cai

Isso não quer dizer que veículos de imprensa estão isentos de erros, e existem diversos casos de que esses veículos passam informações falsas por diversos motivos, desde fontes que mentem para jornalistas, jornalistas sem ética que inventam fontes ou até mesmo manipulação proposital da notícia. Mas o próprio fazer jornalístico, que exige a confirmação de uma informação com várias fontes e necessita que, antes da publicação de uma matéria, saibamos exatamente a origem dessa informação, diminui bastante as chances de propagar notícias falsas — principalmente quando ela está sendo tratada do mesmo jeito por toda a grande imprensa e a imprensa especializada.

Assim, não há exatamente uma forma de garantir que você nunca estará sujeito ou nem será enganado por um deepfake (ou uma notícia falsa), mas seguir esses conselhos ajudará a diminuir bastante as chances de ser enganado por campanhas de desinformação. Também é importante ficar de olho em sites de fact checking (como o boatos.org, ou a Agência Lupa), pois a razão de existência desses sites é simplesmente pesquisar e garantir de uma informação que foi divulgada por alguma figura pública ou que está viralizando na internet é ou não real, salvando que você tenha o trabalho de fazer essa pesquisa por si mesmo.

No geral, navegar na internet se desviando de vídeos e notícias falsas é quase como andar por um campo minado, onde mesmo tomar cuidado com cada passo dado, não é garantia de que você irá pisar em uma bomba. Mas isso não é motivo para deixarmos nosso detector de metal no carro e sair correndo pelo campo sem olhar onde estamos pisando. Espalhar essas informações para que todos saibam o perigo que correm é a melhor maneira de se evitar danos custosos para a sociedade.